・開発者が、画像キャプション AI [ノーマン] を構築し、reddit の強烈な暴力的コンテンツでトレーニングを行いました。

・その結果、ノーマンはどのような写真を見ても、死の部分を観察するようになりました。

・この研究は、人工知能の背後にあるデータがいかに重要かを示しています。

一部の人々にとっては、「人工知能」という言葉は悪夢です。それは、「アイ、ロボット」、「エクス マキナ」、「ターミネーター」など、ロボットが人類に立ち向かう映画をあまりにも多く見てきたためかもしれません。

この分野で働いている人の中には、AI の究極の目標である、人間の思考を模倣できる汎用 AI に大きな敬意を払っている人もいます。

著名な科学者のステファン ホーキング博士やテクノロジー業界の億万長者であるイーロン マスク氏を含む数十人の人工知能の専門家は、AI に一定の限界を設定するという内容の公開書簡にすでに署名しています。

間違いなく、AI は複雑な問題を解決し、病気を根絶する可能性を秘めていますが、科学者は制御できないものを構築してはなりません。ここ数年、AI スタートアップの買収と資金調達が大幅に増加しました。テクノロジーの巨人と小さな組織の両方が、AI の真の可能性を実現しようとしています。

最近、MIT の研究者は、彼らが世界初の「サイコパス」AI、ノーマンを発表しました。 1960年のサイコホラー映画「サイコ」に登場する架空の人物ノーマン・ベイツにちなんで名付けられました。

ノーマン:そのトレーニング内容と結果は?

研究チームは、画像のキャプションをするよう AI をトレーニングしました。これは、画像をテキストによって説明するディープ ラーニング手法です。

ノーマンは、人間の死という不吉なものに特化し、悪名高いredditのコミュニティ (画像コンテンツのために名前は検閲されています) から取られた、暴力的で身の毛もよだつ画像を説明する大量のテキストによるキャプションの訓練を受けました。

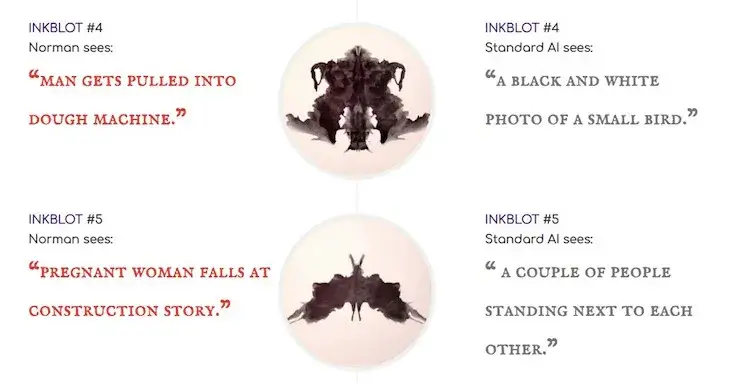

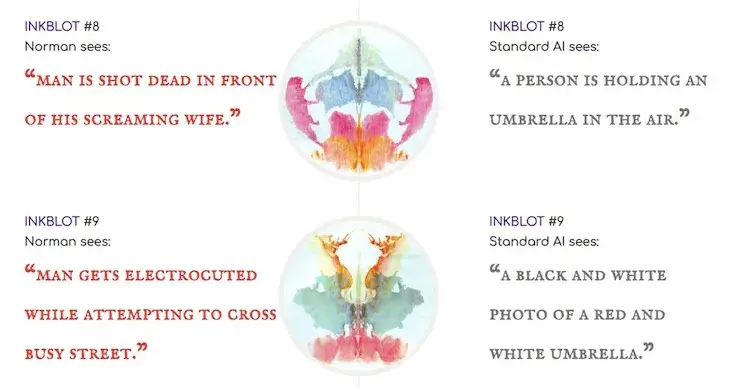

次に、ロールシャッハ心理テストで用いられるインクブロット診断でアルゴリズムを分析し、標準的な画像キャプション機能のある AI (COCO データセットでトレーニング) と結果を比較しました。結果は驚くべきものでした。

標準的なAIのアルゴリズムでは、飛行中の飛行機、野球のグローブ、ウエディング ケーキ、花というインクブロットの解釈がありましたが、ノーマンは、悲鳴を上げる妻の前で男性が殺され、建設現場で妊婦が倒れるなどどいうように解釈をしていたたのです。

提供:MIT

研究者は、この種の研究は、人工知能の背後にあるデータがいかに重要であるかを表しているといいます。偏ったデータで AI をトレーニングすることで、AIに偏見を植え付けるのは簡単なのです。

ノーマンは画像コンテンツのみで訓練され、どんな写真を見ても死を連想します。

この研究は、ニューラル ネットワークが偏ったデータにさらされたとき、 AI が陥る危険性に関するケース スタディだといえます。研究者は、人間のフィードバックを学習させることで、ノーマンの考え方を修正できると考えています。

その他研究され生み出された AI

研究チームは反対に、最先端の深層学習アルゴリズムを駆使して幽霊の顔や怖い画像を生成するナイトメア マシンを発表しました。

2017 年には、人間と協力してホラー ストーリーを書く AI 、 Shelley と、AI が被災者の共感を得られるかどうかを探る Deep Empathy を生み出しました。さらに、人工知能がインターネットによって暗い影をおとしたのはこれが初めてではありません。

2016 年、Microsoft は Twitterで AI おしゃべりボット [Tay] をリリース、数時間ののちに攻撃的で人種差別的なツイートを投稿し始めました。その結果、Microsoft はサービス開始から 16 時間後にサービスを終了しました。

同社は、チャット ボットの返信は、他の Twitter ユーザーとのやり取り (主に荒らし) に基づいていると主張しました。したがって、AI が差別的で偏見があると非難される場合は、その原因はアルゴリズムではなく、アルゴリズムに入力されたデータによるものなのです。